Come l’ultima innovazione di Microsoft può animare volti da fotografie, trasformando opere d’arte e foto in video realistici.

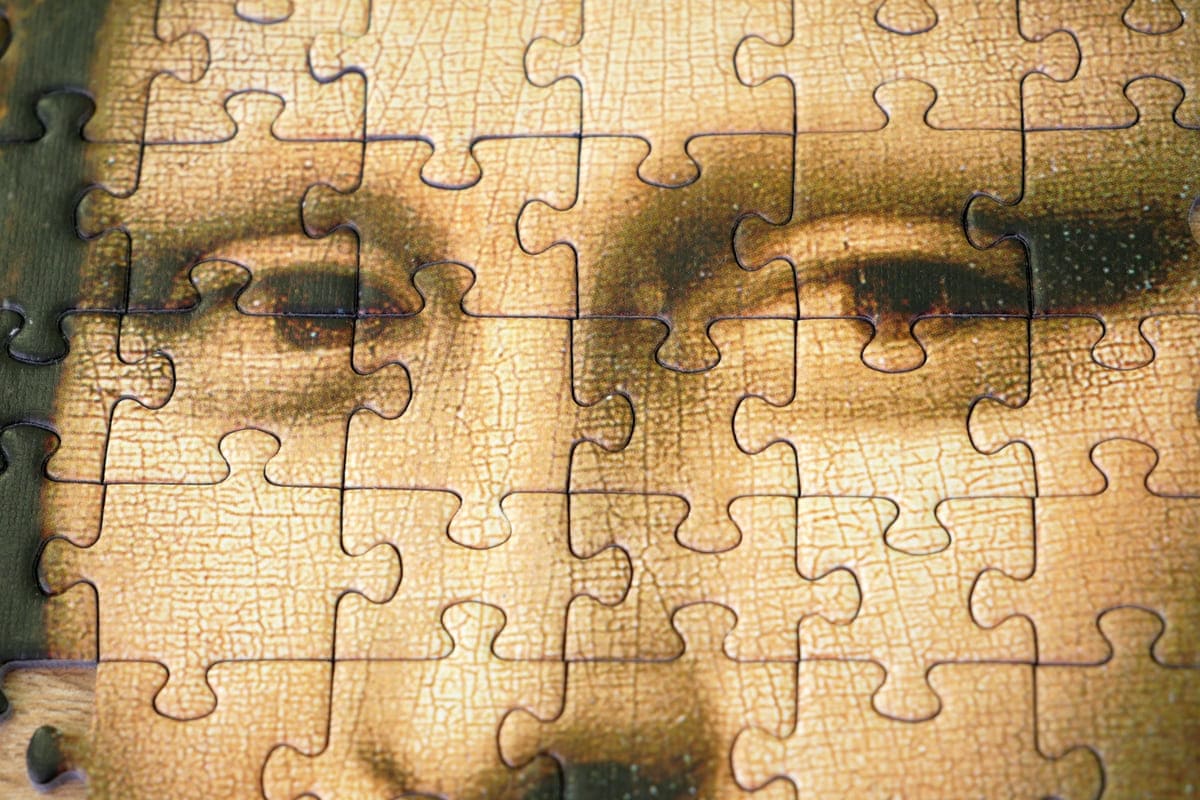

Grazie alla recente innovazione nel campo dell’intelligenza artificiale da parte di Microsoft, il volto della Mona Lisa acquista nuova vita. I ricercatori di Microsoft hanno sviluppato un modello AI, denominato VASA-1, che può prendere un’immagine statica di un viso e un clip audio e trasformarli in un video realistico in cui il soggetto parla. Questa tecnologia non si limita a volti fotorealistici, ma si estende anche a cartoni animati e opere d’arte, dotando i video di un sincronismo labiale convincente e movimenti naturali del viso e della testa.

Un esempio sorprendente: la Gioconda rapper

In un video dimostrativo, i ricercatori hanno mostrato come hanno animato la Mona Lisa per recitare un rap comico dell’attrice Anne Hathaway. Le applicazioni del modello VASA-1 sono sia divertenti che leggermente inquietanti per il loro realismo. Microsoft ha indicato che questa tecnologia potrebbe essere utilizzata in ambito educativo o per “migliorare l’accessibilità per individui con difficoltà comunicative“, o potenzialmente per creare compagni virtuali per gli umani. Tuttavia, è facile intuire come lo strumento possa essere abusato e utilizzato per impersonare persone reali.

L’introduzione di strumenti capaci di generare immagini, video e audio AI convincenti porta con sé il rischio di nuove forme di disinformazione. Alcuni temono anche che la tecnologia possa disturbare industrie creative, dalla cinematografia alla pubblicità. Microsoft ha annunciato che non ha intenzione di rilasciare il modello VASA-1 al pubblico immediatamente. In modo simile, il partner di Microsoft, OpenAI, ha gestito preoccupazioni simili attorno al suo strumento di video generato da IA, Sora, rendendolo disponibile solo a un numero limitato di utenti professionali e professori di cybersecurity per scopi di test.

Microsoft e i suoi ricercatori hanno affermato di opporsi a “qualsiasi comportamento che crei contenuti ingannevoli o dannosi di persone reali“, aggiungendo che non prevedono di rilasciare il prodotto pubblicamente “fino a quando non saranno certi che la tecnologia verrà utilizzata in modo responsabile e in conformità con le dovute regolamentazioni“.

Un passo avanti nell’animazione facciale

Il modello AI di Microsoft è stato allenato su numerosi video di persone mentre parlano, ed è progettato per riconoscere movimenti naturali del viso e della testa, inclusi “movimento delle labbra, espressioni (non legate alle labbra), sguardo degli occhi e battito di ciglia, tra gli altri”. Il risultato è un video più realistico quando VASA-1 anima una foto statica. Ad esempio, in un video demo con un clip audio di qualcuno che suona agitato durante un videogioco. Il viso parlante mostra sopracciglia corrucciate e labbra strette.

Sebbene ci siano ancora segni che i video sono generati da macchine, come il lampeggio infrequente e movimenti esagerati delle sopracciglia, Microsoft afferma che il suo modello “supera significativamente” altri strumenti simili e “spiana la strada a interazioni in tempo reale con avatar realistici che emulano comportamenti conversazionali umani”.